Gondolkozott már azon azon, hogy tudna -e futtatni valami olyan dolgot, mint a chatgpt helyben a Mac -en anélkül, hogy az internetre lenne szükség? Csak egy kis beállítással valójában megteheti. Ez is ingyen. Függetlenül attól, hogy a csevegéseit privátaná akarja tartani, vagy csak offline hozzáférést akar az AI -hez, a következőképpen tudja futtatni a nagy teljesítményű nagy nyelvű modelleket helyben a Mac -en.

#image_title

Mire van szüksége egy LLM helyben futtatásához Mac -en?

Mielőtt belemerülnénk és megnéznénk a beállítást, itt van, amire szüksége lesz:

A nevű ingyenes szerszámot fogjuk használniOlama, amely lehetővé teszi az LLM -ek letöltését és futtatását csak néhány parancsgal. Így lehet elindulni:

1. lépés: Telepítse a Homebrew -t (hagyja ki, ha már telepítve van)

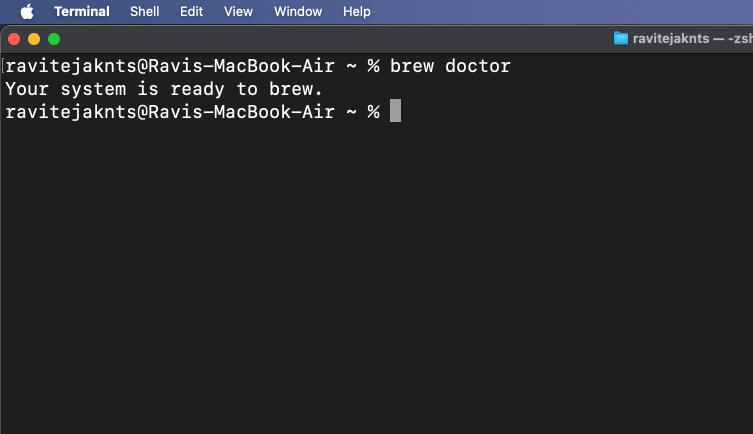

A Homebrew a MacOS csomagkezelője, amely segít az alkalmazások telepítésében a terminál alkalmazásból. Ha már van telepítve a HomeBrew -t a Mac -re, akkor kihagyhatja ezt a lépést. De ha nem, akkor itt van, hogyan telepítheti:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"brew doctor

Ha látja, hogy „a rendszer készen áll a főzésre”, akkor jó menni.

Ha bármilyen problémája van, vagy egy részletesebb lépésről lépésre szeretne, olvassa el az útmutatónkat a Homebrew Mac-re történő telepítéséről.

2. lépés: Telepítse és futtassa az olámát

Most, hogy a Homebrew telepítve van és készen áll a Mac -re, telepítsük az Olámát:

brew install ollamaollama serve

Hagyja nyitva ezt az ablakot, vagy minimalizálja. Ez a parancs folyamatosan a háttérben fut.

Alternatív megoldásként töltse le aOllama alkalmazásés telepítse úgy, mint bármelyik szokásos Mac alkalmazás. Miután elkészült, nyissa meg az alkalmazást, és tartsa a háttérben.

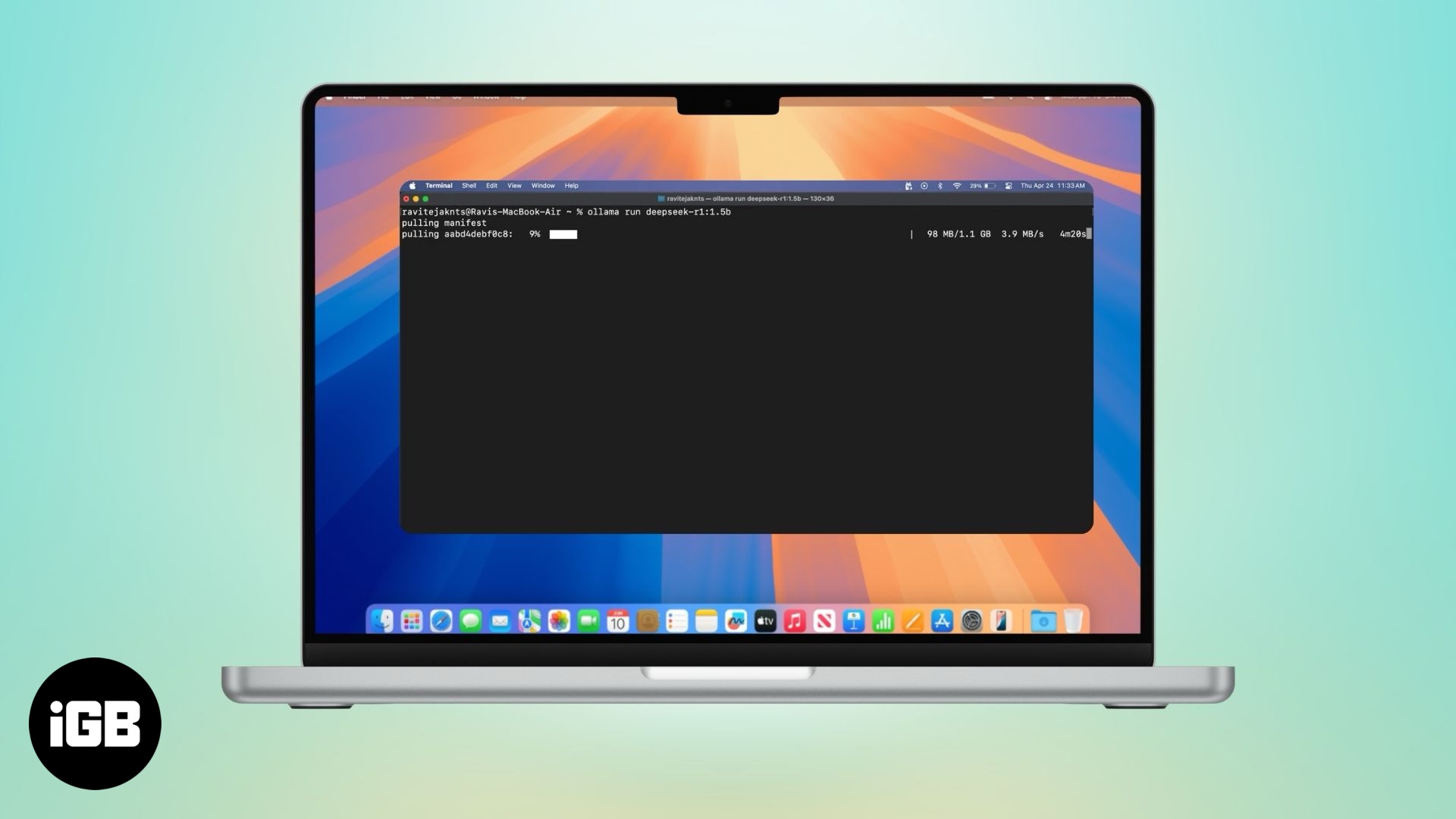

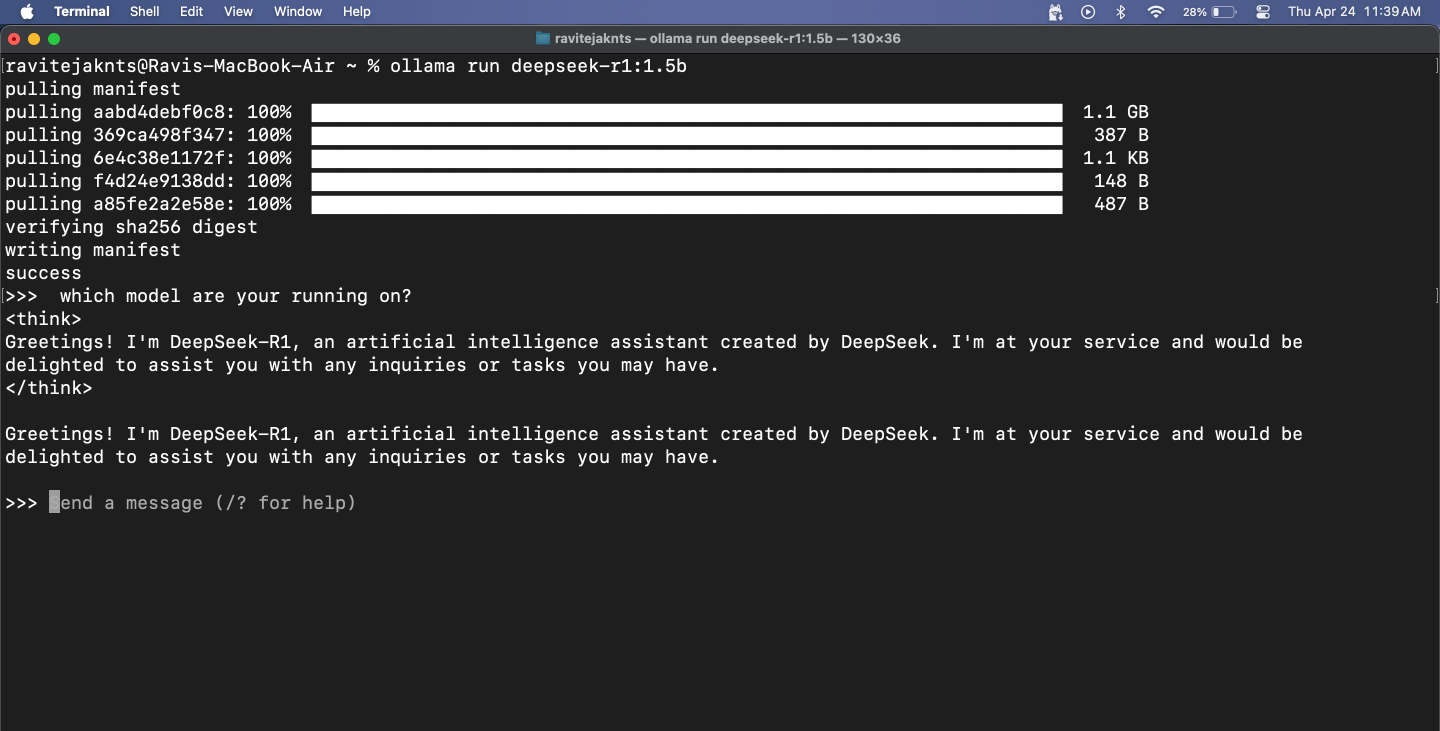

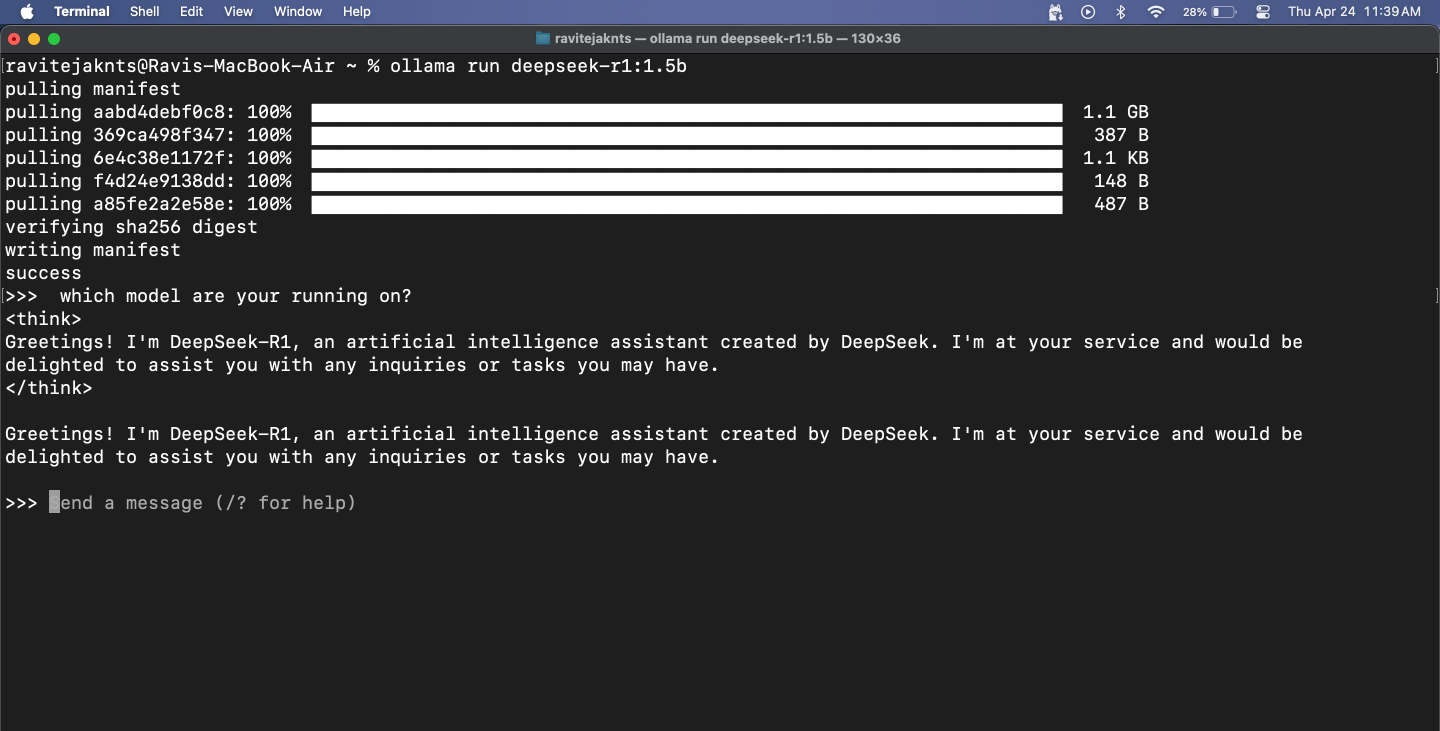

3. lépés: Töltse le és futtasson egy modellt

Az Olla hozzáférést biztosít a népszerű LLM -ekhez, mint például a DeepSeek, a Meta's Llama, a Mistral, a Gemma és még sok más. Így választhat és futtathat egyet:

Ha egy nagy modellt választ, várjon valamilyen késést - az egész modell után a teljes modell helyben fut a MacBook -on. A kisebb modellek gyorsabban reagálnak, de pontossággal küzdhetnek, különösen a matematikai és a logikával kapcsolatos feladatok esetén. Ne feledje azt is, hogy mivel ezeknek a modelleknek nincs internet-hozzáférése, nem tudnak valós idejű információkat hozni.

Ennek ellenére olyan dolgokra, mint például a nyelvtan ellenőrzése, e -mailek írása vagy ötletbörze, ragyogóan működnek. A MacBook-on széles körben használtam a DeepSeek-R1-et egy webes felhasználói felület beállítással, amely lehetővé teszi a képek feltöltését és a kódrészletek feltöltését. Noha a válaszok-és különösen a kódolási képességei-nem olyan élesek, mint a legfelső szintű modellek, mint például a Chatgpt vagy a DeepSeek 671B, még mindig a legtöbb mindennapi feladatot elvégzi az internetre.

4. lépés: Csevegjen a modellel a terminálon

Miután a modell fut, egyszerűen beírhatja az üzenetét, és nyomja meg a gombotVisszatérés- A modell közvetlenül az alábbiakban reagál.

A munkamenetből való kilépéshez nyomja meg a gombotControl+DA billentyűzeten. Amikor újra el akarja kezdeni a csevegést, csak használja ugyaneztollama run [model-name]parancs. Mivel a modell már letöltött, azonnal elindul.

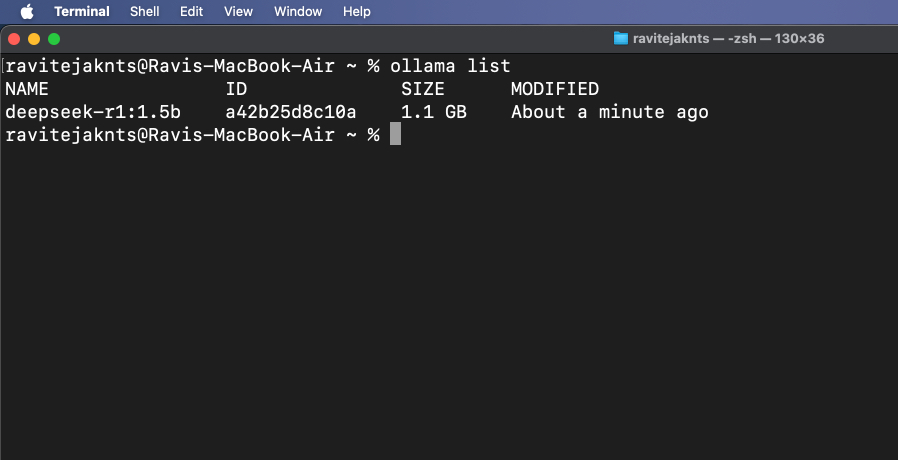

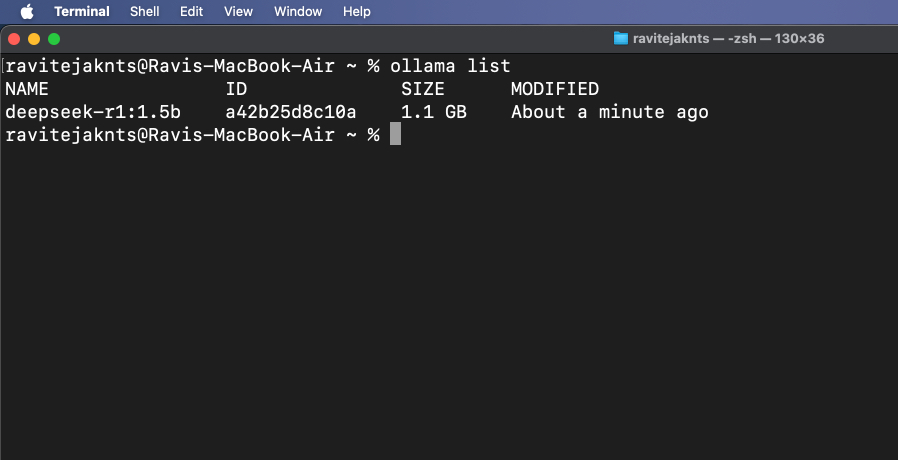

5. lépés: A telepített modellek megtekintése és kezelése

Annak ellenőrzéséhez, hogy mely modelleket töltsön le jelenleg, futtassa:

ollama list

Egy olyan modell törléséhez, amelyre már nincs szüksége, használja:

ollama rm [model-name]Bónusz: Használja az Olámát egy felhasználói felületen az interneten

Miközben Olla a terminálon fut, egy helyi API -szolgáltatást indít a https: // localhost: 11434 oldalon, lehetővé téve, hogy csatlakozzon egy webes felülethez a modellekkel való vizuális interakcióhoz - hasonlóan a chatbot használatához. Az egyik népszerű lehetőség erre az Open Webui, amely felhasználóbarát felületet biztosít az Ollama alapvető funkcionalitásának tetején. Lássuk, hogyan kell beállítani.

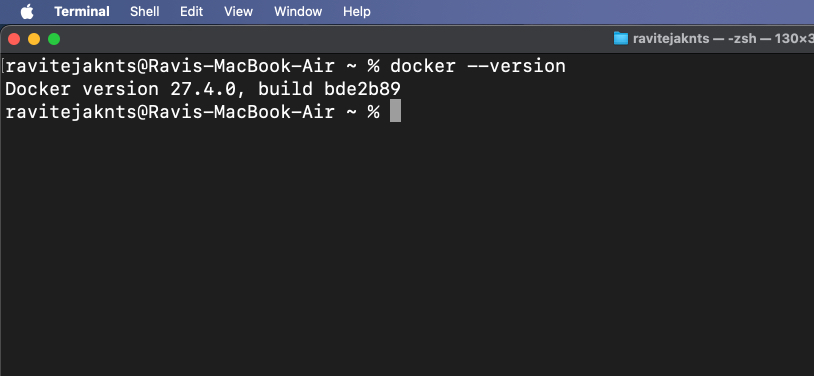

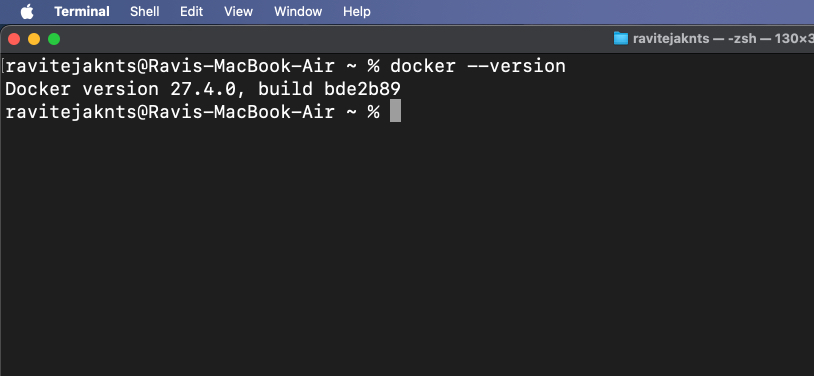

1. lépés: Telepítse a Docker -t

A Docker egy olyan eszköz, amely lehetővé teszi a programot és annak minden alapvető elemét egy hordozható tartályba, így bármilyen eszközön könnyen futtathatja. Használjuk azt egy webes csevegőfelület megnyitására az AI modellhez.

Ha a Mac -nek még nem rendelkezik, kövesse ezeket a lépéseket a Docker telepítéséhez:

docker --version

Ha a parancs visszaad egy verziószámot, ez azt jelenti, hogy a Docker telepítve van a Mac -re.

2. lépés: Húzza ki a nyitott webui képet

Az Open Webui egy egyszerű eszköz, amely csevegőablakot ad a böngészőben. A kép húzása csak azt jelenti, hogy letöltjük a futtatáshoz szükséges fájlokat.

Ehhez menjen aTerminálApp és Type:

docker pull ghcr.io/open-webui/open-webui:mainEz letölti a felülethez szükséges fájlokat.

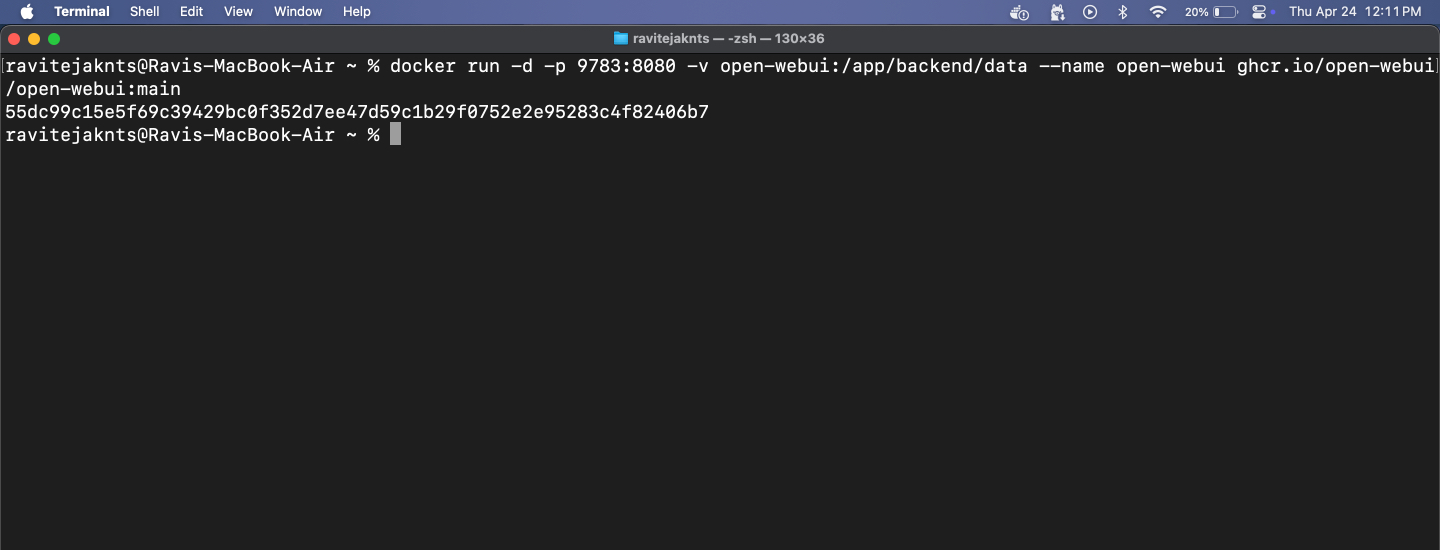

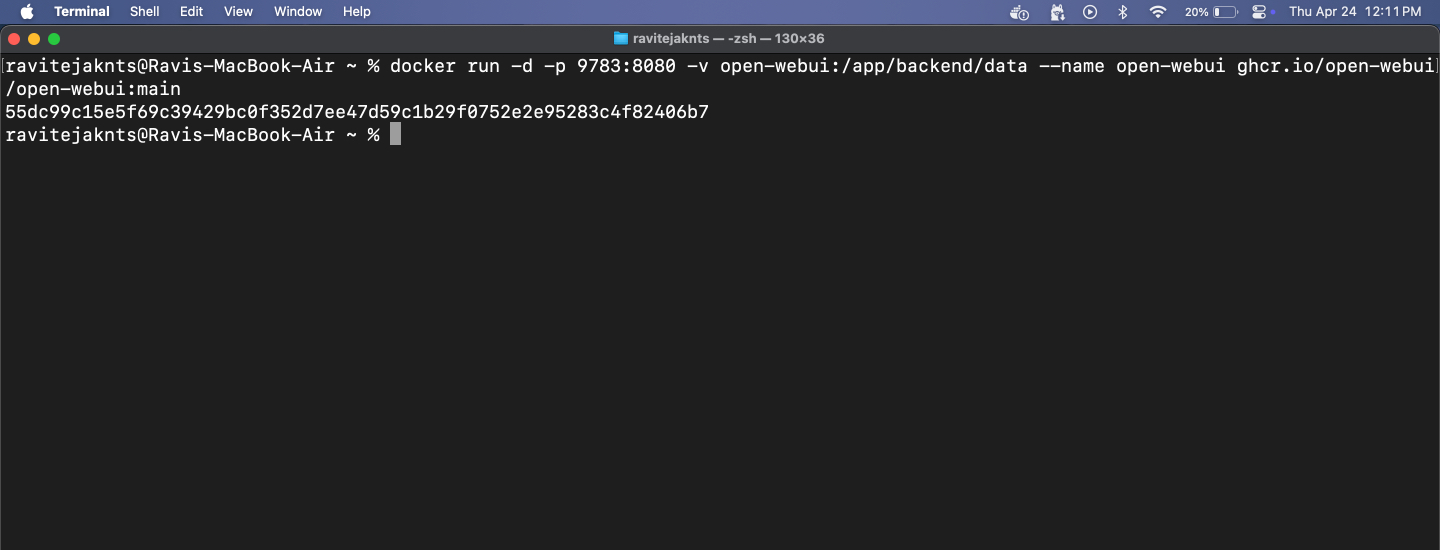

3. lépés: Futtassa a Docker Containert, és nyissa meg a Webui -t

Itt az ideje, hogy a Docker használatával futtassa az Open Webui -t. Látni fog egy tiszta felületet, ahol beszélgethet az AI -vel - nincs szükség. Itt van, amit meg kell tennie:

docker run -d -p 9783:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

https://localhost:9783/

ÖSSZEFÜGGŐ:A File Explorer rendszergazdaként futtatása a Windows 11 -ben

Innentől cseveghet bármilyen telepített modellel egy tiszta, felhasználóbarát böngésző felületen. Ez a lépés opcionális, de simább csevegési élményt nyújt a terminál használata nélkül.

A mac, az ai: nincs szerver, nincs húr

Ennyi! Csak néhány lépésben beállította a Mac -et, hogy egy hatalmas AI modellt teljesen offline módon futtasson. Nincs fiók, nincs felhő és nincs szükség internetre a beállítás után. Akár privát beszélgetéseket, helyi szöveges generációt szeretne, akár csak az LLM -ekkel kíván kísérletezni, az Ollama megkönnyíti és hozzáférhetővé teszi - még akkor is, ha nem fejlesztő vagy. Próbáljuk meg!

Nézze meg ezeket a hasznos útmutatókat is: