Viivästyttyään CSAM Detection for iCloud Photos -sovelluksen julkaisua Apple on vihdoin irrottanut kiistanalaisen turvaominaisuuden. Wired raportoi, että teknologiayritys on nyt päättänyt keskittyä viestintäturvallisuuteen viestien sijaan estääkseen uuden CSAM:n (Child Sexual Abuse Material) syntymisen.

Vuonna 2021 Apple julkisti kolme uutta lasten turvaominaisuutta kaikille laitteille, joilla varmistetaan lasten verkkoturvallisuus ja estetään CSAM:n leviäminen: Safe Communication in Messages, CSAM Detection ja älykäs Siri ja Search tarjoavat ohjeita vaarallisiin verkkovuorovaikutuksiin.

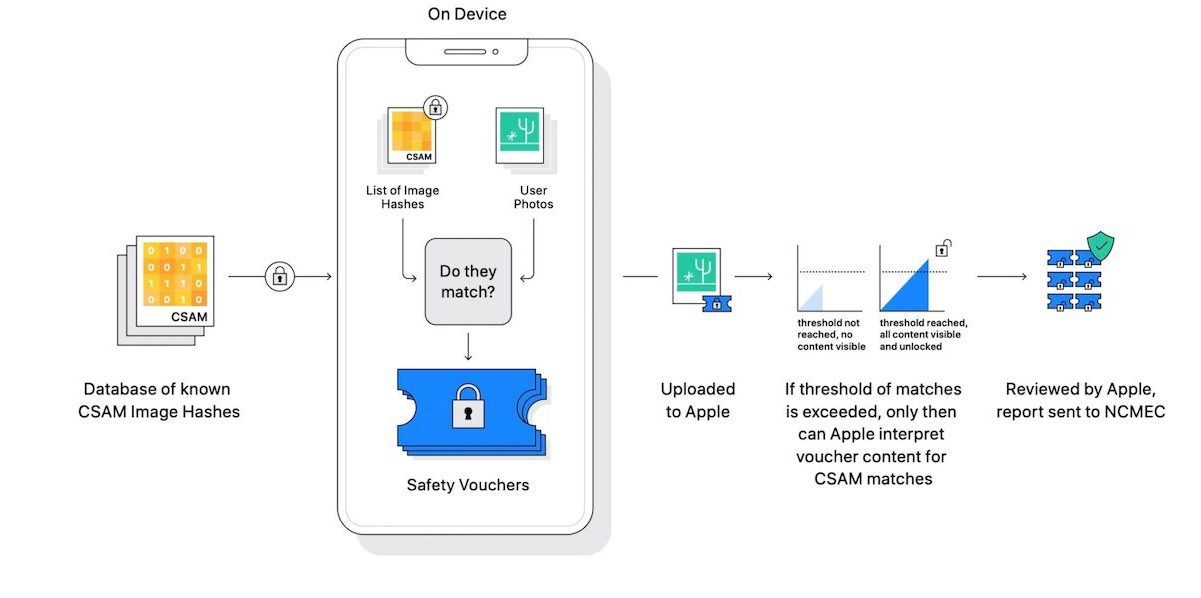

Tietoturva- ja tietosuojaasiantuntija ilmaisi kuitenkin välittömästi huolensa CSAM Detection for iCloud Photos -ominaisuuden mahdollisesta väärinkäytöstä, sillä se olisi käyttänyt hajautusjärjestelmää skannaamaan ja täsmäämään käyttäjien valokuvat NCMEC:n toimittamien tunnettujen hajautusten varalta latauksen aikana pilveen. Nyt on vahvistettu, että CSAM Detection for iCloud Photos ei koskaan käynnisty. Yritys sanoi:

"Käymme laajasti asiantuntijoiden kanssa palautetta viime vuonna ehdottamistamme lastensuojelualoitteista, joten lisäämme investointejamme joulukuussa 2021 ensimmäisen kerran käyttöönotettuun viestintäturvallisuusominaisuuteen.

Olemme lisäksi päättäneet olla jatkamatta aiemmin ehdottamaamme CSAM-tunnistustyökalua iCloud Photosille. Lapsia voidaan suojella ilman, että yritykset läpikäyvät henkilötietoja, ja jatkamme yhteistyötä hallitusten, lasten asiamiesten ja muiden yritysten kanssa auttaaksemme suojelemaan nuoria, säilyttämään heidän oikeutensa yksityisyyteen ja tekemään internetistä turvallisemman paikan lapsille ja meille kaikille.

Apple päivittää Communication Safety for Messages -sovelluksen siten, että se pystyy havaitsemaan alastomuuden videoissa

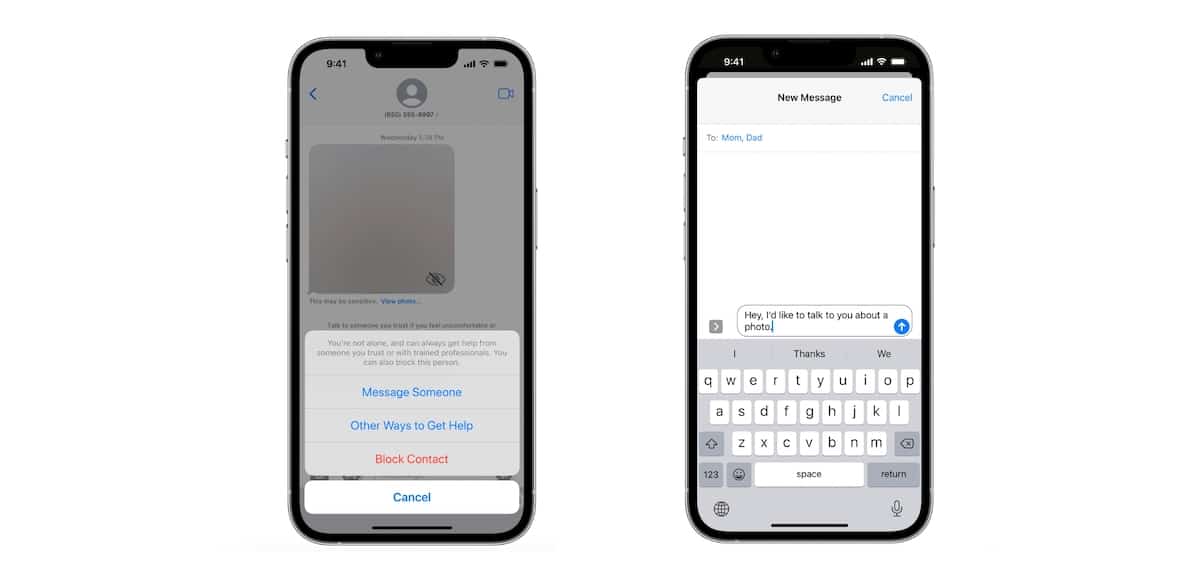

iOS 15.2:ssa Apple julkaisi Communication Safety in Messages -sovelluksen, joka on valinnainen turvallisuusominaisuus, joka on suunniteltu perhejakosuunnitelman omaaville vanhemmille tai huoltajille suojaamaan nuoria iPhone-käyttäjiä avoimelta sisällöltä. Kun ominaisuus on käytössä, se analysoi Viestit-sovelluksessa lähetetyt ja vastaanotetut kuvat alastomuuden tai CSAM:n varalta.

Jos ominaisuus havaitaan, se sumentaa kuvaa ja näyttää varoituksen, että kuva voi olla herkkä, kuten yksityisiä osia, se voi vahingoittaa ja se on voitu jakaa ilman kuvassa olevan henkilön lupaa. Nuorelle vastaanottajalle ilmoitetaan myös, että se ei ole hänen vikansa ja että hän voi puhua kokemuksesta luotettavan henkilön kanssa jakamalla viestin "aikuisen" kanssa.

Investoinneilla teknologiayritys pyrkii lisäämään alastomuuden tai CSAM:n havaitsemisen Messagesin tai kolmannen osapuolen viestisovellusten kautta jaetuissa videoissa, kun viestintäturva on käytössä.

"Mahdollinen lasten hyväksikäyttö voidaan keskeyttää ennen kuin se tapahtuu tarjoamalla opt-in työkaluja vanhemmille auttaakseen suojelemaan lapsiaan vaaralliselta viestinnältä", yhtiö sanoi lausunnossaan. "Apple on omistautunut kehittämään innovatiivisia yksityisyyttä suojelevia ratkaisuja torjuakseen lasten seksuaalista hyväksikäyttöä koskevaa materiaalia ja suojellakseen lapsia samalla kun vastataan henkilökohtaisen viestinnän ja tietojen tallennuksen ainutlaatuisiin tietosuojatarpeisiin."

Lisäksi teknologiajättisanoiettä se jatkaa myös yhteistyötä lasten turvallisuuden asiantuntijoiden kanssa helpottaakseen hyväksikäyttämisestä ilmoittamista CSAM:n leviämisen estämiseksi. Erin Earp, seksuaalisen väkivallan vastaisen järjestön RAINNin väliaikainen varapuheenjohtaja, sanoi:

CSAM-skannaus ennen materiaalin lähettämistä lapsen laitteella on yksi näistä työkaluista, ja se voi auttaa rajoittamaan ongelman laajuutta.

Tällä hetkellä Communications Safety for Messages on saatavilla Yhdysvalloissa, Kanadassa, Isossa-Britanniassa, Australiassa ja Uudessa-Seelannissa.

Lue myös:Applen CSAM-tunnistusdilemma – Tech-jätti selittää, miksi se luopui CSAM-tunnistustyökaluista

Lue lisää:

- Viestintäturvallisuuden ottaminen käyttöön helposti iOS 15.2:ssa

- Applen mukaan lasten turvallisuuden "Messages-analyysijärjestelmä" ei katkaise päästä päähän -salausta Messagesissa

- Googlen tekemä CSAM-hajautusvirhe ajaa vanhemman vaikeuksiin ja herättää enemmän epäilyksiä Applen CSAM-tunnistuksesta

- Digitaalisten oikeuksien ryhmä EFF kehottaa Applea luopumaan CSAM-suunnitelmastaan kokonaan

- Apple vahvistaa, että se skannaa iCloud Mailista CSAM:ia, mutta ei vielä iCloud Photosia